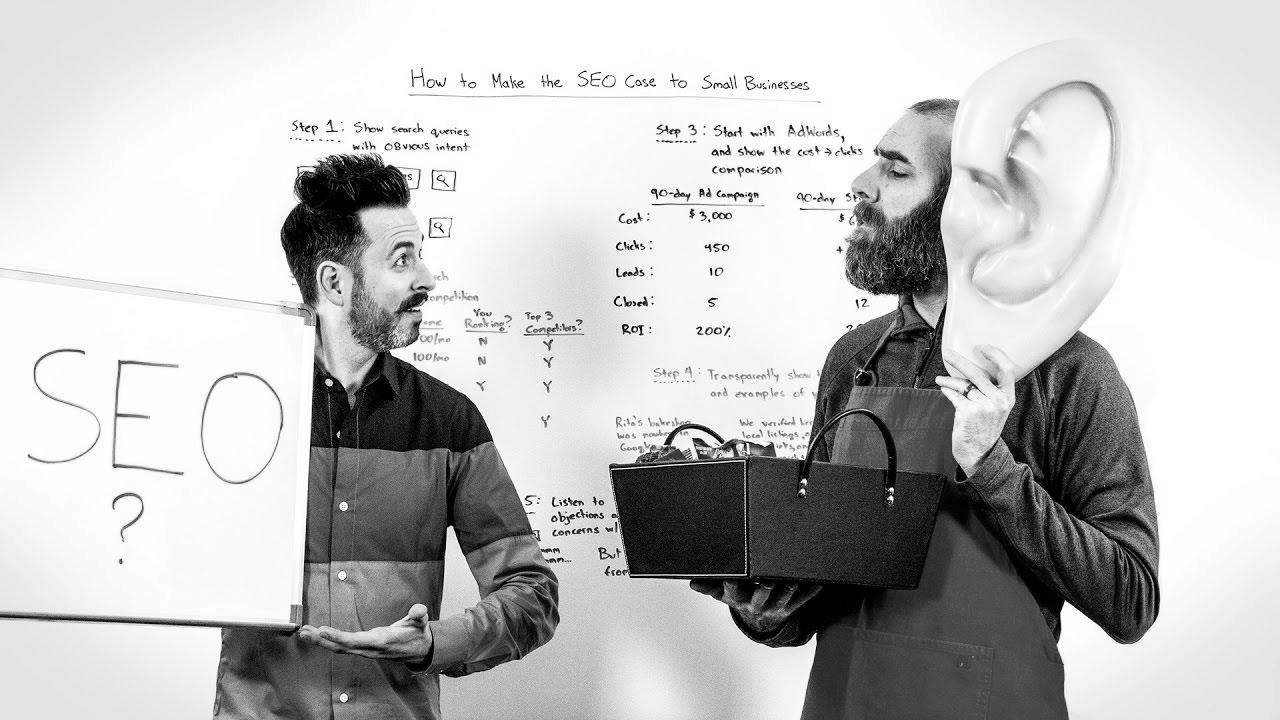

Methods to Make the website positioning Case to Small Companies – Whiteboard Friday

Warning: Undefined variable $post_id in /home/webpages/lima-city/booktips/wordpress_de-2022-03-17-33f52d/wp-content/themes/fast-press/single.php on line 26

Make Search engine optimization , How you can Make the website positioning Case to Small Businesses - Whiteboard Friday , , _z8dFyfks5o , https://www.youtube.com/watch?v=_z8dFyfks5o , https://i.ytimg.com/vi/_z8dFyfks5o/hqdefault.jpg , 1743 , 5.00 , https://moz.com/blog/make-seo-case-small-businesses-whiteboard-friday Perception in the course of may be the make-or-break factor ... , 1483911618 , 2017-01-08 22:40:18 , 00:09:11 , UCs26XZBwrSZLiTEH8wcoVXw , Moz , 9 , , [vid_tags] , https://www.youtubepp.com/watch?v=_z8dFyfks5o , [ad_2] , [ad_1] , https://www.youtube.com/watch?v=_z8dFyfks5o, #search engine optimization #Case #Small #Businesses #Whiteboard #Friday [publish_date]

#search engine marketing #Case #Small #Companies #Whiteboard #Friday

https://moz.com/blog/make-seo-case-small-businesses-whiteboard-friday Perception within the course of can be the make-or-break factor ...

Quelle: [source_domain]

- Mehr zu SEO Mitte der 1990er Jahre fingen die allerersten Suchmaschinen im Netz an, das frühe Web zu ordnen. Die Seitenbesitzer erkannten rasch den Wert einer bevorzugten Positionierung in Ergebnissen und recht bald fand man Anstalt, die sich auf die Verbesserung ausgebildeten. In den Anfängen ereignete sich die Aufnahme oft über die Übermittlung der URL der geeigneten Seite an die verschiedenen Suchmaschinen. Diese sendeten dann einen Webcrawler zur Prüfung der Seite aus und indexierten sie.[1] Der Webcrawler lud die Webpräsenz auf den Webserver der Anlaufstelle, wo ein weiteres Softwaresystem, der allgemein so benannte Indexer, Infos herauslas und katalogisierte (genannte Ansprüche, Links zu weiteren Seiten). Die zeitigen Modellen der Suchalgorithmen basierten auf Infos, die durch die Webmaster eigenhändig vorliegen werden konnten, wie Meta-Elemente, oder durch Indexdateien in Suchmaschinen im Netz wie ALIWEB. Meta-Elemente geben eine Gesamtübersicht via Content einer Seite, jedoch registrierte sich bald raus, dass die Benutzung dieser Vorschläge nicht zuverlässig war, da die Wahl der gebrauchten Schlagworte dank dem Webmaster eine ungenaue Beschreibung des Seiteninhalts repräsentieren vermochten. Ungenaue und unvollständige Daten in Meta-Elementen vermochten so irrelevante Seiten bei einzigartigen Recherchieren listen.[2] Auch versuchten Seitenersteller mehrere Merkmale innert des HTML-Codes einer Seite so zu lenken, dass die Seite passender in den Suchergebnissen gelistet wird.[3] Da die neuzeitlichen Suchmaschinen im Internet sehr auf Gesichtspunkte dependent waren, die alleinig in den Fingern der Webmaster lagen, waren sie auch sehr instabil für Missbrauch und Manipulationen im Ranking. Um überlegenere und relevantere Resultate in den Ergebnissen zu erhalten, mussten sich die Inhaber der Suchmaschinen im Internet an diese Umständen integrieren. Weil der Gewinn einer Recherche davon zusammenhängt, wichtigste Suchresultate zu den gestellten Keywords anzuzeigen, vermochten untaugliche Resultate dazu führen, dass sich die Anwender nach anderweitigen Optionen bei der Suche im Web umsehen. Die Lösung der Suchmaschinen im Netz fortbestand in komplexeren Algorithmen beim Rangfolge, die Faktoren beinhalteten, die von Webmastern nicht oder nur nicht leicht beeinflussbar waren. Larry Page und Sergey Brin konstruierten mit „Backrub“ – dem Stammvater von Yahoo – eine Recherche, die auf einem mathematischen Suchalgorithmus basierte, der anhand der Verlinkungsstruktur Websites gewichtete und dies in Rankingalgorithmus reingehen ließ. Auch andere Search Engines relevant während der Folgezeit die Verlinkungsstruktur bspw. wohlauf der Linkpopularität in ihre Algorithmen mit ein. Yahoo